ollama国内镜像下载中文版安装包来了,是Facebook AI Research公司开发的模型工具,ollama官网下载很慢,小编花费半天时间总算下载下来分享给大家;大家注意ollama只是一个工具,他内置了多种llm大型语言模型,也可以导入本地模型文件使用,注意不能直接导入,需要编写一个配置文件,再来导入!还可以通过安装ollama,来实现deepseek本地部署使用!

ollama是一个开源的大型语言模型(LLM)本地化部署与管理工具,旨在简化在本地计算机上运行和管理大语言模型的流程。它支持多种主流开源模型(如Llama、Mistral、DeepSeek、Qwen等),并通过命令行工具、API接口及丰富的社区生态,为开发者、研究人员和爱好者提供了高效、灵活的本地AI应用开发环境。

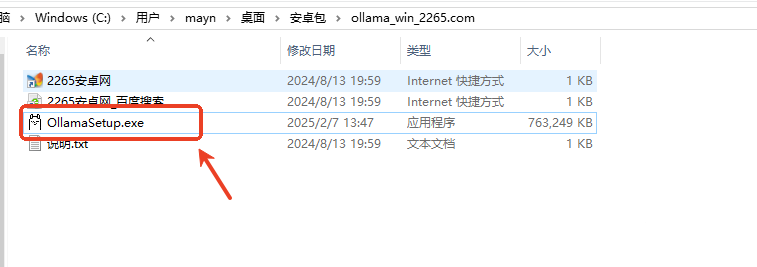

解压后,运行ollamasetup.exe;

弹出安全警告,点击“运行”;

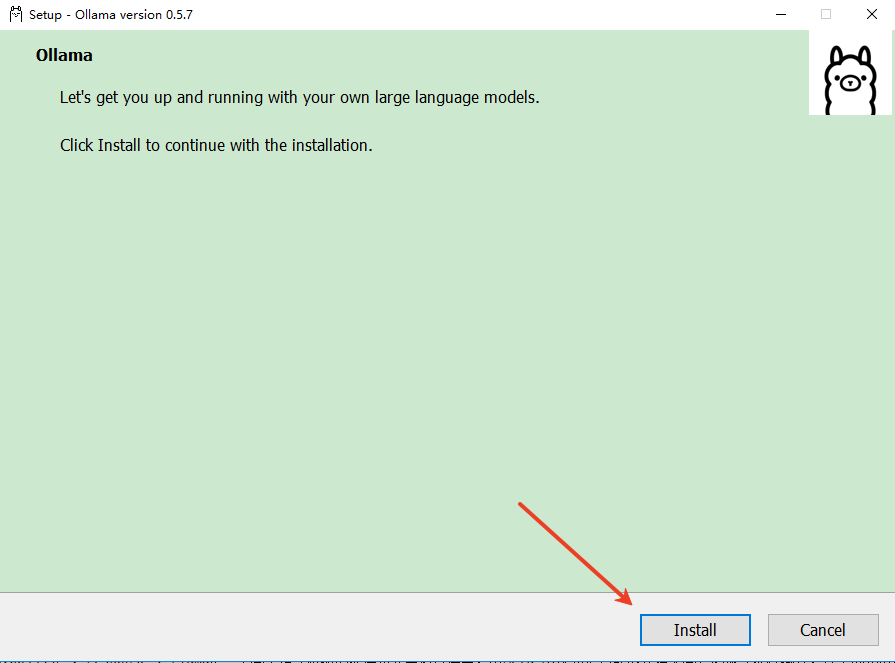

开始安装,点击“install”,片刻后就能安装完成。

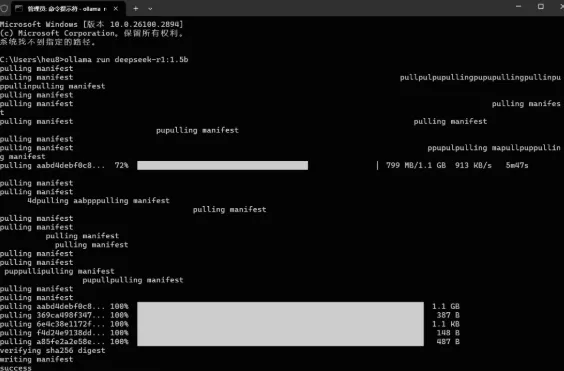

如搭配DeepSeek使用,DeepSeek模型版本有许多:比如1.5b、7b、8b、14b、32b、70b 671b,版本越高越强大,但是对电脑GPU要求也越高。根据你电脑的配置选择合适的版本,每一个版本都对应一个安装命令,把它复制下来。

DeepSeek-R1

ollama run deepseek-r1:671b

DeepSeek-R1-Distill-Qwen-1.5B

ollama run deepseek-r1:1.5b

DeepSeek-R1-Distill-Qwen-7B

ollama run deepseek-r1:7b

DeepSeek-R1-Distill-Llama-8B

ollama run deepseek-r1:8b

DeepSeek-R1-Distill-Qwen-14B

ollama run deepseek-r1:14b

DeepSeek-R1-Distill-Qwen-32B

ollama run deepseek-r1:32b

DeepSeek-R1-Distill-Llama-70B

ollama run deepseek-r1:70b

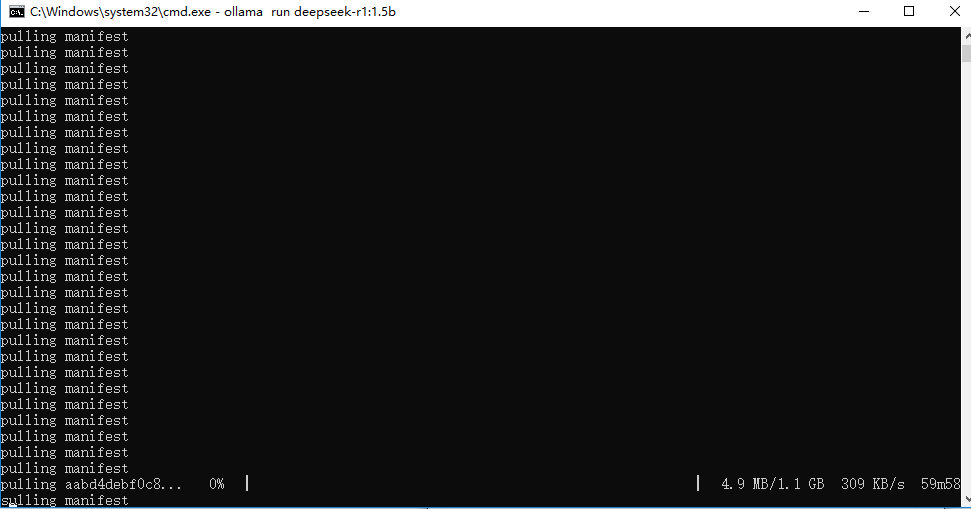

然后在CMD命令框,输入上述命令。例如:ollama run deepseek-r1:1.5b,便可以自动在线部署安装。

部署成功后,我们可以使用命令窗口直接输入你想问的问题。

API与多语言支持

RESTAPI:兼容OpenAI接口标准,开发者可通过/api/generate和/api/chat接口生成文本或实现对话功能。

客户端集成:支持Python、Java、C#等语言调用,便于与其他应用程序(如Web界面、桌面客户端)集成。

硬件加速与资源优化

GPU加速:在支持CUDA或Metal的设备上,可通过GPU显著提升推理速度。

资源管理:通过环境变量(如OLLAMA_KEEP_ALIVE控制模型内存驻留时间、OLLAMA_MAX_VRAM限制显存占用)优化硬件资源使用。

本地化部署

Ollama支持在macOS、Linux和Windows(预览版)系统上运行,无需依赖云端服务。用户可通过Docker容器或直接安装包部署,确保数据隐私与低延迟响应。

模型管理便捷

模型仓库:提供预构建的模型库(如Llama3、Phi3、Gemma2等),用户可通过ollamapull快速下载。

自定义模型:支持通过Modelfile定义模型参数(如温度值、系统提示),并基于现有模型创建个性化版本。例如,可让模型以特定角色(如马里奥)回答问题。

多模型并行:支持同时加载多个模型,并通过调整num_ctx参数控制上下文长度。

硬件要求

内存:最低8GB内存,推荐16GB或更高

显卡:支持NVIDIA和AMD显卡,建议使用至少8GB显存的显卡,如NVIDIA的30、40系列或AMD的T4、V100、A10等系列

处理器:最低8核处理器,推荐16核或更高

存储:至少100GB的存储空间

软件依赖

Docker:某些功能可能需要Docker支持

Python:用于高级功能开发

企业知识库与RAG应用

结合检索增强生成(RAG)技术,本地部署模型可安全处理敏感数据。例如,使用OllamaRAGChatbot与本地PDF文件交互。

多模态与代码生成

支持多模态模型(如LLaVA)分析图像,或通过CodeLlama生成代码片段9。

本地对话与开发测试

通过命令行直接运行模型(如ollamarunllama3),或使用Web客户端(如LobeChat、OpenWebUI)实现可视化交互。

Ollama凭借其本地化部署、灵活配置和丰富的社区支持,成为探索大语言模型的理想工具。对于初学者,建议从轻量级模型(如Mistral7B)入手,逐步熟悉命令与API;企业用户可结合RAG和私有化部署,构建安全高效的AI应用。

动作格斗1.01G

扮演角色1.13G

办公管理52.7M

热门手游3.0M

生活服务58.7M

生活服务51.1M

热门手游4.4M

生活服务28.3M

网络游戏156.7M